A publica sau a nu publica?

Unul din produsele principale ale cercetării științifice îl reprezintă publicaţiile, fie în jurnale de specialitate, fie în volume de conferinţă. Aceste publicaţii au ca rol diseminarea rezultatelor cercetărilor efectuate de un grup sau altul din comunitatea ştiinţifică. Structura unui articol ştiinţific este oarecum standardizată în prezent, fiind compus dintr-o introducere, în care se prezintă starea actuală a domeniului şi ce aduce nou articolul respectiv, o secţiune în care se prezintă ipotezele de start, metodele şi materialele utilizate în experimente, apoi se prezintă rezultatele obţinute şi explicaţii pentru acestea (eventual însoţite de simulări teoretice care să confirme rezultatele experimentale), iar la final se trag nişte concluzii şi se prezintă referinţele care au stat la baza articolului şi a discuţiilor din acesta. Publicaţiile ajută comunitatea ştiinţifică dintr-un domeniu sau altul să se cunoască, să se testeze şi să îşi valideze rezultatele, să comunice, eventual să deschidă noi colaborări pentru a avansa acele rezultate cu potenţial ridicat de valorificare în piaţă. Din publicaţii îşi extrag de multe ori ideile şi firmele private, pentru noi produse, tehnologii, etc. Oricum, publicaţiile sunt o parte importantă a CV-ului unui cercetător, dacă nu cumva cea mai importantă, pentru că pe baza lor poate câştiga proiecte şi poate avansa în carieră. Problema este însă că rolul publicaţiilor a fost puternic distorsionat în ultimele decade prin introducerea indicatorilor scientometrici şi lansarea junalelor open-access.

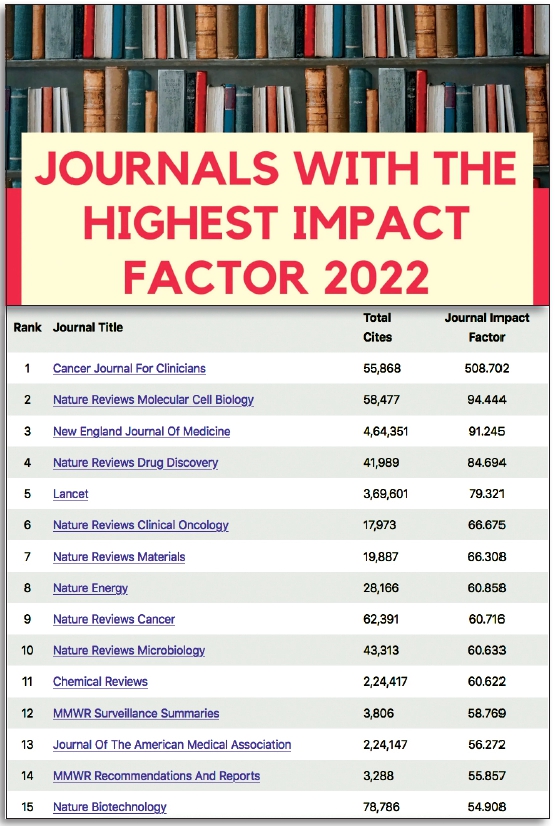

Primul indicator scientometric important a fost factorul de impact. Acesta se calculează ca raport între suma citărilor articolelor publicate într-un jurnal în doi ani anteriori anului curent şi numărul articolelor citabile publicate în respectivul jurnal în cei doi ani anteriori (a se vedea spre exemplu https://researchguides.uic.edu/if/impact). Factorul de impact (abreviat din engleza IF), după cum îi spune şi numele, măsoară în fapt impactul articolelor publicate într-un jurnal. Cu cât IF are o valoare mai mare se consideră că impactul jurnalului respectiv în comunitatea ştiinţifică este mai mare. Exemple clasice sunt Nature şi Science, deşi nu au cel mai mare factor de impact. Sunt jurnale din domeniul sănătăţii, biologiei sau medicinii care au factor de impact mai mare decât cele două (a se vedea https://impactfactorforjournal.com/journals-with-impact-factor/). Deşi a fost introdus încă din 1955 de către Eugene Garfield (a se vedea https://pubs.aip.org/physicstoday/Online/12144/Origins-of-the-journal-impact-factor), fondator şi al Institute for Scientific Information (de unde şi expersia de jurnale indexate ISI), IF nu a fost prea mult băgat în seamă la început. Cercetătorii dintr-un anumit domeniu aveau jurnale de tradiţie în care încercau să publice fără să îşi pună problema mărimii factorului de impact al jurnalelor respective. Spre exemplu, pentru fizică aplicată importante erau Applied Physics Letters şi Journal of Applied Physics, pentru fizică teoretică erau Physical Review Letters şi Physical Review (divizat apoi în mai multe secţiuni, în funcţie de domeniul din Fizică pe care îl abordau), pentru filme subţiri era Thin Solid Films, etc. Era o perioadă în care numărul de jurnale era relativ restrâns, iar cantitatea de articole publicate nu era chiar aşa de mare, iar informarea cu ce a mai apărut nou într-un domeniu sau altul se putea face în linişte într-o sală de bibliotecă.

Absolutizarea indicatorilor scientometrici și „impactul” lor nedorit

Treptat însă IF a început să fie important pentru acordarea granturilor şi pentru promovarea în carieră ştiinţifică. Agenţiile finanţatoare şi evaluatorii utilizaţi de acestea nu aveau timp să stea să citească producţia ştiinţifică a unui cercetător şi să o compare cu a altuia atunci când trebuiau să decidă cui să dea fondurile pentru un grant. La fel şi pentru o comisie care decidea pe cine promovează şi pe cine nu. S-a făcut apel deci la IF, pe considerentul că cine publică într-un jurnal cu IF mai mare este mai bun decât cineva care publică în alt jurnal cu IF mai mic. A început deci să conteze nu atât calitatea articolelor publicate de cineva şi impactul lor măsurat prin citările colectate în anii ulteriori publicării, cât calitatea jurnalului în care a fost publicat articolul, calitate măsurată prin IF. Stresul de a publica în jurnale cu IF cât mai mare a crescut, astfel încât cercetătorii nu se mai concentrează pe calitatea muncii şi a rezultatelor lor, ci pe publicarea cât mai rapidă a ceva în jurnale cu IF mare (de unde şi sintagma „Publish or perish”, vezi https://www.researchgate.net/publication/335617031_Publish_ethically_or_perish). O astfel de abordare poate genera probleme de etică atât din partea cercetătorilor, cât şi din partea colectivelor editoriale ale jurnalelor. În goana de a publica rapid şi bine, cercetătorii pot neglija cu bună ştiinţă anumite aspecte ale activităţii lor (ex. date statistice, verificarea validităţii datelor, se poate ajunge la date false care să confirme anumite teorii, sau chiar la plagiat). Pe de altă parte, editorii pot „îngrăşa” IF al jurnalului solicitând citări ale unor articole publicate în acelaşi jurnal sau limitând foarte mult numărul de articole publicate în jurnalul respectiv (aşa numitul screening editorial, cu justificări de genul „am mai publicat ceva similar”, „avem prea multe articole primite şi nu vrem să îi stresam pe referenţii noştri”, „simt că articolul nu se adresează unei largi audienţe”, „nu comentăm calitatea tehnică, dar credem că articolul este potrivit pentru un jurnal mai specializat” şi altele similare). Pe baza citărilor anterioare culese de articolele publicate de un anumit cercetător sau grup de cercetare editorii încep să favorizeze acei cercetători sau acele grupuri de cercetare în detrimentul altora, astfel încât să poate ajunge la situaţii în care afilierea autorilor unui articol să fie mai importantă decât calitatea ştiinţifică a acestuia. Asta pentru că citările anterioare sunt considerate un fel de garanţie a calităţii rezultatelor produse de un cercetător sau grup de cercetare de la o anumită organizaţie, preferabil din topurile universitare internaţionale sau membră a unei asociaţii de institute de cercetare recunoscute internaţional.

Între timp, pe lângă IF au mai apărut şi alţi indicatori scientometrici, precum suma totală a citărilor, scorul de influenţă a articolului (abreviere în engleză AIS), împărţirea jurnalelor pe quartile după IF, AIS sau alte măsuri scientometrice, etc. Stresul pe cercetător a crescut şi mai mult, pentru că unele agenţii finanţatoare se uită la IF, altele la AIS, altele la quartile, un jurnal care este în Q1 după IF nu este în Q1 şi după AIS, şi aşa mai departe.

Alți „factori” echivoci

Alt stres vine din faptul că trebuie neapărat să publici ca autor principal (la noi se consideră autor principal primul autor sau autorul corespondent) şi să ai un factor Hirsch (H) cât mai mare. Se desconsideră faptul că modul în care se stabileşte ordinea autorilor unui articol poate diferi de la o ţară la alta şi chiar de la o instituţie la alta. Sigur, toţi autorii trebuie să fi adus o contribuţie oarecare la elaborarea articolului, unii pot avea însă contribuţii esenţiale iar alţii pot avea contribuţii mai mici, ordinea poate reflecta aceste contribuţii sau nu (de aceea din ce în ce mai multe jurnale solicită să se menţioneze contribuţia autorilor la un articol). Cert este că a considera ca autor principal doar pe primul autor sau pe autorul corespondent este o simplificare care creează iarăşi stres cercetătorilor. În multe cazuri primul autor este un doctorand sau un post-doc, şi nu el este neapărat cel care a avut ideea studiului respectiv, după cum autorul corespondent este cel desemnat de către toţi autorii să ţină legătura cu editura la care este trimis articolul, fără ca asta să însemne că a avut contribuţia cea mai mare la conceperea articolului. În multe cazuri autorul corespondent este profesorul sau şeful de grup, în alte cazuri este cel care a obţinut grantul, deci poate a avut ideea studiului, dar nu înseamnă că a şi conceput articolul în prima formă, poate doar l-a supervizat şi corectat (dacă era cazul). Corect ar fi să se ia în considerare contribuţia unui cercetător la toate articolele pe care le consideră relevante pentru o propunere de proiect, nu neapărat doar cele la care este autor principal. Arta de a atrage fonduri nu se rezumă doar la a publica în jurnale Q1 ca autor principal, ci la a dovedi că eşti capabil să conduci echipe de cercetare şi să propui proiecte credibile şi de impact. Asta înseamnă, ca evaluator, să te uiţi la portofoliul de proiecte anterioare ale propunătorului şi la rezultatele pe care le-au produs. Sigur, la început de carieră poate fi mai greu să câştigi proiecte, iar lucrările produse anterior pot cântări consistent în a convinge un evaluator că poţi livra rezultatele promise în proiect. Cu timpul însă, pe măsură ce CV-ul creşte cu noi lucrări şi proiecte câştigate, ar trebui să conteze cât mai mult calitatea proiectului şi capacitatea managerială şi educativă a propunătorului. Despre factorul H nu mai are rost să vorbesc, este o mărime uşor manipulabilă şi nu reflectă corect calitatea unui cercetător. Cum se poate spune că un cercetător cu H 200 (adică 200 de lucrări cu cel puţin 200 citări fiecare) este mai bun decât unul cu H 10 (spre exemplu 10 lucrări cu câte 1000 citări fiecare)?

Distorsiunile induse de open-access

După cum am spus în primul paragraf, o altă distorsiune în cultura publicaţiilor ştiinţifice a fost introdusă de apariţia jurnalelor open-access. Un scurt istoric al conceptului de open-access aplicat la publicaţiile ştiinţifice se poate găsi la https://blogs.harvard.edu/openaccess101/what-is-open-access/what-is-open-access/. Se constată că introducerea open-access a venit ca răspuns la creşterea substanţială a costurilor cu abonamentele clasice şi a fost facilitată de extinderea internetului, ceea ce a însemnat acces facil şi rapid la publicaţii. Încetul cu încetul, conceptul s-a extins şi astăzi multe agenţii de finanţare solicită ca rezultatele din proiectele pe care le finanţează să fie publicate în jurnale open-access sau să fie făcute disponibile în diferite depozite electronice (repositories). Cumva, extinderea accesului liber la publicaţiile ştiinţifice este de înţeles, mai ales în cazul proiectelor finanţate din fonduri publice, când se presupune că rezultatele obţinute sunt un bun public, în măsura în care nu lezează anumite drepturi de proprietate intelectuală. Numai că politica open-access contravine politicilor editoriale ale jurnalelor, care presupun cedarea aproape totală a drepturilor de multiplicare, reproducere, diseminare către editura care publică jurnalul. În principiu, nu poţi distribui după bunul plac un articol publicat într-un jurnal pentru că încalci acordul de copyright semnat înainte de publicarea articolului şi eşti pasibil de acţiuni judecătoreşti prin care jurnalul încearcă să îşi recupereze eventuale daune provocate de expunerea publică a articolului respectiv (exemplu, nu mai percepe taxe de acces). Ca să rezolve în oarecare măsură problema, au fost introduse taxe de open-access, adică un jurnal care în mod normal nu percepe taxe pentru publicare şi diseminare, oferă posibilitatea a plăti o taxă prin care articolul tău devine open-access imediat (gold open access) sau după o anumită perioadă de timp (green open-access, diferenţa între cele două este explicată la https://scientific-publishing.webshop.elsevier.com/publication-process/difference-between-green-gold-open-access/). Problema este că taxele pentru open-access sunt ridicate, pot ajunge uşor la mii de euro sau USD. Nu mulţi autori îşi permit să plătească aceste taxe, ele sunt în general preluate de către organizaţii de cercetare care plătesc pentru lucrările open-access ale angajaţilor lor, având înţelegeri în acest sens cu diferitele edituri care publică jurnale ştiinţifice. Astfel de politici au însă numai organizaţii mari de cercetare, ţările mai puţin bogate nu îşi permit astfel de cheltuieli. Şi totuşi, publicarea open-access este impusă de agenţiile de finanţare din tot mai multe ţări, chiar dacă nu există resurse financiare pentru asta. Se mută cheltuiala cu abonamente, şi aşa foarte ridicate, în cheltuiala cu publicare open-access.

Răspândirea internetului, corelată cu politicile open-access din ce în ce mai agresive au dus la o explozie de jurnale la editurile consacrate (Elsevier, Wiley, Sprringer-Nature, ACS, AIP, APS, IOP, etc.), dar a dus şi la apariţia de edituri care publică numai open-access (ex. Hindawi, MDPI, Bentham, PLOS şi altele, vezi https://en.wikipedia.org/wiki/Category:Open_access_publishers). Apare astfel o competiţie între editurile consacrate, recunoscute internaţional de zeci de ani, şi editurile mai noi care publică doar open-access. Competiţia vine de la faptul că publicaţiile ştiinţifice reprezintă o piaţă ca orice piaţă, din care se pot face profituri frumoase (o piaţă estimată la peste 10 miliarde USD în 2020, vezi https://www.researchandmarkets.com/reports/5406470/global-scientific-and-technical-publishing-2021-2025). Profituri fie din abonamente (calea clasică), fie din open-access (calea modernă, facilitată de internet). Interesant este că toată lumea accepta acest lucru, deşi este clar o deturnare de fonduri publice, prin care se finanţează cercetarea, către afaceri private foarte profitabile, şi asta indiferent că se plăteşte abonament sau taxa open-access. Nota bene, evaluatorii care fac peer-review la jurnalele ştiinţifice fac muncă voluntară, ei nu sunt plătiți. Nu este foarte clar pe ce se duc banii, sigur există nişte costuri de producţie pentru jurnalele care scot încă şi ediţii pe hârtie, probabil că sunt plătiţi unii editori şi oarece personal adminsitrativ, dar în cazul jurnalelor complet digitalizate nu este clar cât din bani se duc pe costuri de producţie şi personal şi cât se duc direct în profit net. În orice caz, concurența este clară între edituri, de unde şi tendinţa de ponegrire a unora de către alţii (consacraţii versus editurile noi total open-access). Aşa a apărut noţiunea de predatory journals, considerate ca jurnale care fac concurenţă neloială celor consacrate, încălcând chiar regulile de etică în cercetare (se pot citi mai multe la: https://www.nature.com/articles/d41586-019-03759-y; https://mdanderson.libanswers.com/faq/206446; https://paperpile.com/g/predatory-journals/; https://predatoryreports.org/news?blogcategory=Predatory+Publishing şi altele). Definiţia unui predatory journal nu este încă foarte clară, dar se acceptă că un jurnal care nu face publice condiţiile de publicare şi taxa open-access, nu are sistem de peer-review, nu are o pagină web credibilă, are un timp anormal de scurt între momentul în care primeşte un manuscris şi momentul la care îl publică, utilizează abuziv adresele de e-mail ale cercetătorilor pentru a îi invită să trimită articole spre publicare, este, foarte posibil, un predatory journal. Există o pagină web numită Directory of Open Access Journals, considerată de încredere în a selecta un jurnal open access fără riscul de a fi predatory (vezi https://doaj.org/). Clarivate Analytics, care manageriază Web of Science şi Journal of Citations Report, are la rândul ei anumite filtre pe baza cărora delistează jurnale care par a deveni predatory, spre exemplu dacă au o creştere fulminantă a numărului de articole publicate într-un an (vezi ultima delistare la https://www.linkedin.com/pulse/web-science-de-listed-82-journals-march-2023-sofia-fields/). Se constată că au fost delistate jurnale de la o multitudine de edituri, inclusiv de la unele considerate respectabile, cum ar fi Springer, Wiley sau Elsevier. A cataloga o editură ca fiind predatory doar pentru că are 2-3 jurnale delistate de către Clarivate este deja un abuz. Cum ar fi să spunem că şi Springer, Wiley sau Elsevier sunt şi ele predatory pentru că au şi ele 2-3 jurnale delistate? Semne de întrebare există şi în cazul unor jurnale publicate de numitele edituri respectabile, cum ar fi Scientific Reports, un jurnal în Nature Portfolio (vezi discuţiile de pe unele formuri precum https://www.quora.com/Is-Scientific-Reports-a-good-journal sau https://www.researchgate.net/post/Is_Nature_Scientific_Reports_a_good_reputable_journal). Interesantă şi opinia de la http://bjoern.brembs.net/2019/12/elsevier-now-officially-a-predatory-publisher/, din care rezultă că Elsevier bifează cele mai importante puncte din definiţia unei edituri predatory. Alte opinii interesante se regăsesc la https://www.nature.com/articles/d41586-021-00239-0.

Având în vedere cele de mai sus, apare ca fiind deplasată recomandarea care se găseşte în pachetele de informaţii pentru competiţii TE şi PCE, aflate în dezbatere publică până pe 4 mai, că jurnalele MDPI (Multidisciplinary Digital Publishing Institute – editor de reviste ştiinţifice open access) ar trebui desconsiderate în procesul de evaluare a directorului de proiect, şi că publicarea rezultatelor proiectului în jurnale MDPI nu este susţinută. Mai jos este un screen print al celor mai mari contributori cu articole la jurnale MDPI din ultimii 10 ani, cei care se iau în considerare la respectivele competiţii:

Lăsând la o parte Academia Chineză de Ştiinţe, putem spune că CNRS-Franța, CNR-Italia, CSIC-Spania, Univ. din Munchen sau Univ. din Oxford sunt organizaţii de cercetare care nu dau atenţie jurnalelor în care îşi publică rezultatele? Este adevărat că MDPI are unele deficienţe, dar din cele peste 400 de jurnale publicate puţin peste 200 sunt indexate în Web of Science, şi numai 2 au fost delistate în martie 2023. Unele sunt chiar respectabile, fără a fi neapărat cu IF astronomic cum sunt alte jurnale de la edituri presupus respectabile. Acestea fiind spuse, nu cred că este cazul să fim noi mai catolici decât Papa!

Sugestii pentru îmbunătățirea politicii evaluării și publicării

Rămân în discuţie însă cele două aspecte care grevează puternic activitatea cercetătorilor, nu numai din România:

- Absolutizarea indicatorilor scientometrici şi transformarea procedurilor de evaluare a proiectelor şi a dosarelor de promovare în simple exerciţii contabile de adunat IF, AIS şi altele similare, de parcă evaluarea se referă la jurnale şi nu la calitatea de cercetător a unei persoane.

- Competiţia open-access şi deturnarea banilor publici către întreprinderi private, care manipulează cum pot piaţa publicaţiilor ştiinţifice pentru a oferi o şansă tuturor, contra bani, bineînţeles.

Opinia persoanala este că evaluările ar trebui să se întoarcă la aprecierea omului, nu a jurnalelor în care publică (spre exemplu, să nominalizeze maxim 10 lucrări la care consideră că a avut o contribuţie esenţială, lucrări pe care evaluatorii să le citească şi să aprecieze în ce măsură acestea justifică ideea de proiect ca fiind fezabilă, sau justifică promovarea în cariera de cercetare; o altă sugestie ar fi competiţii în două etape, cu obligaţia unui interviu în etapa a doua). În ceea ce priveşte open access, propunerile sunt extreme: ori se revine la vechile obiceiuri de publicare şi se elimină complet open access, curăţând în acelasi timp peisajul de jurnale irelevante sau care duplică, triplică, etc. jurnale cu istorie în spate; ori se trece complet la open-access, fără taxe, în depozite controlate de organizaţii publice, eventual de cercetare, şi se desfiinţează editurile pentru profit. Aş spune că astfel de depozite open access ar trebui să fie un fel de forumuri, cu un peer-review classic în primă instanţă, în care corespondenţa între autori şi referenţi să fie publică, urmând ca lucrarea să fie în continuare deschisă discuţiilor pro şi contra, sub supervizarea unui colectiv academic care să elimine formulările discutabile sau eronate din punct de vedere ştiinţific. Aş spune că un boicot general faţă de editurile actuale ar fi binevenit, în paralel cu lansarea unor platforme de publicare total open access fără taxe de publicare pentru autori. Un prim pas a fost făcut de Comisia Europeană prin lansarea platformei Open Research Europe (vezi https://open-research-europe.ec.europa.eu/). Nu este în totalitate o activitate non-profit, din moment ce platforma este manageriată de o firmă privată, iar Comisia plăteşte o taxă fixă pentru fiecare articol produs în proiectele H2020 şi HE, dar este totuşi un început pentru accesul liber la rezultatele cercetărilor finanţate din fonduri publice. Rămâne însă de văzut în ce măsură agenţiile finanţatoare şi decidenţii politici sunt dispuşi să introducă o reformă atât de radicală în politica de publicare.

Tags: Cercetare, productie stiintifica, open access, evaluare cercetare, factor impact, factor Hirsch, indicatori scientometrici

Parerea ta conteaza:

UVT, catalizator al mișcării academice timișorene, își urmează calea spre cunoașterea aprofundată și trecerea către tehnologiile viitorului și ale noilor generațiiUniversitatea de Vest din Timișoara este astăzi cea mai dinamică instituție de învățământ superior din România, o universitate care se...

UVT, catalizator al mișcării academice timișorene, își urmează calea spre cunoașterea aprofundată și trecerea către tehnologiile viitorului și ale noilor generațiiUniversitatea de Vest din Timișoara este astăzi cea mai dinamică instituție de învățământ superior din România, o universitate care se...

Inteligența artificială ca instrument academic: aliat sau capcană?

Inteligența artificială ca instrument academic: aliat sau capcană?