AI Act: Pilonii reglementării Inteligenței Artificiale īn Uniunea Europeană

În ultimul deceniu, progresele semnificative în domeniul inteligenței artificiale (IA) au avut un impact semnificativ asupra multor industrii. Astăzi, tehnologiile AI sunt adoptate pe scară largă, atât în platformele online, cât și în diferite sectoare, inclusiv în producție, sănătate, finanțe și retail. La nivel global, guvernele au început să integreze soluții de inteligență artificială pentru a spori productivitatea, variind de la utilizarea simplă, până la implementarea de sisteme chatbot și sisteme avansate pentru decizii automate. Se estimează că piața IA va crește exponențial, de la o valoare de aproximativ 100 de miliarde de dolari în 2021, la aproape două trilioane de dolari până în 2030.

În ultimul deceniu, progresele semnificative în domeniul inteligenței artificiale (IA) au avut un impact semnificativ asupra multor industrii. Astăzi, tehnologiile AI sunt adoptate pe scară largă, atât în platformele online, cât și în diferite sectoare, inclusiv în producție, sănătate, finanțe și retail. La nivel global, guvernele au început să integreze soluții de inteligență artificială pentru a spori productivitatea, variind de la utilizarea simplă, până la implementarea de sisteme chatbot și sisteme avansate pentru decizii automate. Se estimează că piața IA va crește exponențial, de la o valoare de aproximativ 100 de miliarde de dolari în 2021, la aproape două trilioane de dolari până în 2030.

Conștientizarea faptului că AI reprezintă mai mult decât un trend trecător, accentuată de avântul inteligenței artificiale generative din ultimul an, a motivat multe guverne și organizații internaționale să elaboreze reglementări specifice AI. În acest context, Uniunea Europeană joacă un rol de pionierat prin dezvoltarea Legii AI (AI Act), un instrument juridic important, adoptat la sfârșitul anului 2023 și posibil aplicabil din 2024 sau 2025. Acesta stabilește standarde pentru dezvoltarea, comercializarea și utilizarea sistemelor AI.

În noiembrie 2023, Think Tank 360 reprezentat de Mariana Ungureanu - WiDS Stanford Ambasador Romania, alături de Wolters Kluwer România au organizat cursul : „AI – a panacea or a deadly virus? AI regulation and strategic planning for the private sector”. Cursul a fost livrat de experții internaționali Marius Jitea și Veronica Ștefan și a abordat teme precum: provocările și inovațiile în Inteligența Artificială, abordările de reglementare, beneficiile și limitările viitorului cadru legal.

Iată câteva dintre aspectele abordate în curs.

Ce riscuri identifică AI Act și cum sunt abordate acestea?

Legea privind Inteligența Artificială vizează diminuarea riscurilor asociate cu opiniile părtinitoare umane în sistemele AI, o provocare complexă ce necesită o vigilență sporită. Pentru a se conforma, companiile trebuie să fie foarte conștiente de modelele algoritmice care alcătuiesc sistemele lor de AI, precum și de datele care sunt introduse în sisteme. Combaterea opiniilor părtinitoare în AI nu este doar o problemă tehnică, astfel că o abordare interdisciplinară, implicând o echipă dedicată recunoașterii opiniilor părtinitoare, atât umane, cât și ale mașinilor, este esențială pentru a gestiona această problemă într-un mod cuprinzător.

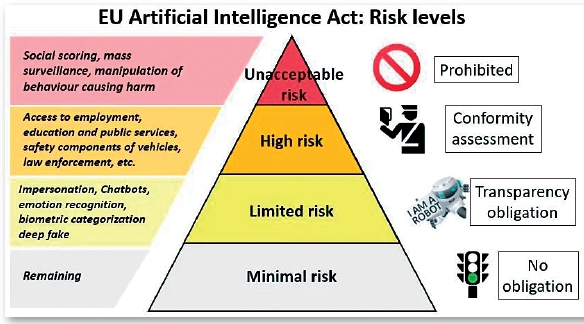

Legea AI recunoaște faptul că nu toate aplicațiile sau implementările AI prezintă același nivel de risc. Astfel, legea clasifică riscurile în patru categorii diferite:

• Inaceptabil: Este strict interzisă utilizarea aplicațiilor ce implică tehnici subliminale, sisteme de manipulare sau sisteme de evaluare socială implementate de autorități. De asemenea, utilizarea sistemelor de recunoaștere biometrică în timp real utilizate de forțele de ordine în spații accesibile publicului este interzisă.

• Risc ridicat: Această categorie cuprinde aplicații în domenii precum transportul, educația, sau angajarea forței de muncă. Înaintea lansării sau implementării unui sistem AI considerat cu risc înalt în Uniunea Europeană, companiile sunt obligate să realizeze o evaluare de conformitate preliminară și să respecte o serie extinsă de cerințe pentru garantarea siguranței sistemului. În plus, ca parte a măsurilor de precauție, Comisia Europeană va trebui să creeze și să actualizeze o bază de date publică, obligând furnizorii să ofere detalii despre sistemele lor AI cu risc înalt, pentru a asigura transparența în fața tuturor actorilor interesați.

• Risc limitat: Această categorie include sistemele AI care trebuie să respecte cerințe explicite de transparență. De exemplu, oricine interacționează cu un chatbot trebuie să fie informat că interlocutorul său este un sistem automatizat, oferindu-i astfel opțiunea de a alege dacă dorește să continue conversația sau dacă preferă dialogul cu un operator uman.

• Risc minim: Aceste tipuri de aplicații sunt răspândite pe o scară largă și constituie majoritatea sistemelor de inteligență artificială utilizate curent. Exemplele includ filtrele anti-spam, jocurile video dotate cu inteligență artificială și sistemele de management a inventarului.

Prin ce se identifică un sistem AI cu risc ridicat?

Alături de o definiție clară a conceptului de „risc înalt”, legislația introduce o metodă robustă pentru a determina care sisteme AI prezintă un risc ridicat. Evaluarea riscului se fundamentează pe finalitatea anticipată a sistemului AI, în linie cu legislația UE. Acest lucru indică faptul că nivelul de risc este evaluat în funcție de rolul sistemului AI, scopul specific și modul în care este utilizat.

O listă anexată legii prezintă scenariile considerate a avea un risc înalt, iar Comisia se angajează să mențină această listă actualizată și relevantă. Sistemele care îndeplinesc funcții limitate și procedurale, care îmbunătățesc rezultatele activităților umane existente și care nu afectează deciziile sau acțiunile umane direct nu sunt considerate cu risc ridicat. Totuși, un sistem AI este considerat ca prezentând un risc înalt dacă realizează profilarea persoanelor.

Câteva exemple de cazuri de utilizare cu risc ridicat, așa cum sunt definite în Legea AI:

• Anumite infrastructuri critice, de exemplu în domeniul traficului rutier și al alimentării cu apă, gaz, încălzire și electricitate;

• Educație și formare profesională, de ex. pentru a evalua rezultatele învățării și a orienta procesul de învățare și monitorizarea înșelăciunii;

• Ocuparea forței de muncă, gestionarea lucrătorilor și accesul la activități independente, de ex. a plasa anunțuri de angajare, pentru a analiza și filtra cererile de angajare și pentru a evalua candidații;

• Accesul la servicii și beneficii esențiale private și publice (de exemplu, asistență medicală), evaluarea bonității persoanelor fizice și evaluarea riscurilor și stabilirea prețurilor la asigurările de viață și de sănătate;

• Anumite sisteme utilizate în domeniile aplicării legii, controlul frontierelor, administrarea justiției și a proceselor democratice;

• Evaluarea și clasificarea apelurilor de urgență;

• Sisteme biometrice de identificare, clasificare și recunoaștere a emoțiilor (în afara categoriilor interzise);

• Sistemele de recomandare ale platformelor online foarte mari nu sunt incluse, așa cum sunt deja acoperite în altă legislație (DMA/DSA).

Care sunt obligațiile furnizorilor de sisteme AI cu risc ridicat?

Înainte de lansarea pe piața UE sau de operarea unui sistem AI considerat cu risc înalt, furnizorii trebuie să efectueze o evaluare a conformității. Aceasta le va oferi posibilitatea de a dovedi că sistemul lor îndeplinește standardele obligatorii stabilite pentru AI de încredere, cum ar fi calitatea datelor, documentația și trasabilitatea, transparența, supravegherea umană, precizia, securitatea cibernetică și robustețea. Evaluarea trebuie actualizată ori de câte ori sistemul sau utilizarea sa suferă modificări semnificative.

Toate sistemele AI ce constituie componente de siguranță ale produselor reglementate de legislația specifică a UE vor fi clasificate ca având risc înalt și vor necesita o evaluare de conformitate de către părți terțe, conform legislației aplicabile în domeniu. Sistemele biometrice necesită, de asemenea, evaluare de conformitate externă. Furnizorii de sisteme AI cu risc înalt trebuie să instituie proceduri de management al calității și al riscurilor pentru a asigura aderența la reglementările noi și pentru a reduce riscurile pentru utilizatori și persoanele afectate, chiar și după introducerea pe piață a produselor.

Sistemele AI cu risc înalt utilizate de autoritățile publice sau de entitățile care acționează în numele acestora trebuie să fie înregistrate într-o bază de date publică a UE, cu excepția celor folosite pentru aplicarea legii și migrație, care vor fi listate într-o secțiune privată accesibilă doar autorităților de supraveghere competente. Autoritățile de supraveghere a pieței vor facilita monitorizarea post-comercializare prin audituri și vor permite furnizorilor să raporteze orice incidente grave sau nerespectări ale drepturilor fundamentale. Autoritățile de supraveghere a pieței pot, în situații excepționale, autoriza lansarea pe piață a unor sisteme AI cu risc înalt. În caz de încălcare, autoritățile naționale vor avea acces la informațiile necesare pentru a verifica dacă sistemul AI a respectat legislația.

Cum sunt reglementate modelele AI de uz general?

Modelele AI de uz general, inclusiv modelele AI generative mari, pot fi utilizate pentru o multitudine de sarcini. Este important ca un furnizor care dorește să se bazeze pe un model AI de uz general să se asigure că sistemul său este sigur și în conformitate cu Legea AI.

Astfel, Legea AI impune ca furnizorii acestor modele să furnizeze informații esențiale către utilizatorii sistemelor, facilitând astfel o mai bună înțelegere a funcționării modelelor respective. Este necesar ca furnizorii de modele să adopte măsuri pentru a asigura conformitatea cu legislația privind drepturile de autor în procesul de antrenare a modelelor. Mai mult, unele modele pot reprezenta riscuri sistemice datorită capabilităților avansate sau utilizării extensive. În prezent, modelele AI generale antrenate cu o capacitate de calcul totală de peste 10^25 FLOP-uri sunt considerate a avea riscuri sistemice, având în vedere că o capacitate mai mare de calcul conferă modelelor o eficacitate crescută. Autoritatea AI (creată în cadrul Comisiei) are prerogativa de a ajusta acest prag pe măsură ce evoluează tehnologia și poate, de asemenea, să clasifice alte modele ca fiind sistemice pe baza criteriilor adiționale, cum ar fi numărul de utilizatori sau nivelul de autonomie al modelului.

Furnizorii de modele cu riscuri sistemice sunt obligați să identifice și să minimizeze riscurile, să raporteze incidentele majore, să realizeze teste de vârf și evaluări ale modelelor, să garanteze securitatea cibernetică și să divulge informații privind consumul de energie al modelelor lor. Ei trebuie să colaboreze cu Oficiul European AI pentru a elabora coduri de conduită, care vor servi drept instrument principal în definirea normelor în colaborare cu alți specialiști. Un comitet științific va avea un rol esențial în monitorizarea modelelor AI generale.

Tags: inteligenta artificiala, AI, reglementare AI, AI Act, legislatie inteligenta artificiala, riscuri AI, sanctiuni AI

Parerea ta conteaza:

UVT, catalizator al mișcării academice timișorene, își urmează calea spre cunoașterea aprofundată și trecerea către tehnologiile viitorului și ale noilor generațiiUniversitatea de Vest din Timișoara este astăzi cea mai dinamică instituție de învățământ superior din România, o universitate care se...

UVT, catalizator al mișcării academice timișorene, își urmează calea spre cunoașterea aprofundată și trecerea către tehnologiile viitorului și ale noilor generațiiUniversitatea de Vest din Timișoara este astăzi cea mai dinamică instituție de învățământ superior din România, o universitate care se...

50 de ani de la absolvirea primei serii de informatică de la Universitatea din București

50 de ani de la absolvirea primei serii de informatică de la Universitatea din București